Standardpflichten im Rechenzentrum Virtualisierung stellt Hochverfügbarkeit und Disaster Recovery auf den Prüfstand

Virtualisierungstechnologien gehören mittlerweile zum festen Bestandteil der Unternehmens-IT. Recht sorglos gehen IT-Entscheider allerdings häufig mit den Aspekten Hochverfügbarkeit und Disaster Recovery in virtuellen Systemumgebungen um.

Anbieter zum Thema

Oft sind virtuelle Maschinen nicht in ein entsprechendes Konzept eingebunden. Sind geschäftskritische IT-Dienste, Applikationen und Hardware in die virtuelle Struktur integriert, wächst das Risiko allerdings enorm: Der physische Server fungiert als Single-Point-of-Failure und zieht im Fall der Fälle auch die darauf laufenden virtuellen Maschinen in den Absturz.

Im toten Winkel: Disaster Recovery

Auslastung, Ressourcenmanagement, Kosteneinsparungen – die Euphorie um die Möglichkeiten mit Virtualisierungstechnologien verstellt manch einem den Blick für Standardpflichten in geschäftskritischen IT-Umgebungen: Etablierte Methoden und Lösungen für das Disaster Recovery (DR) und die Hochverfügbarkeit bleiben häufig außen vor.

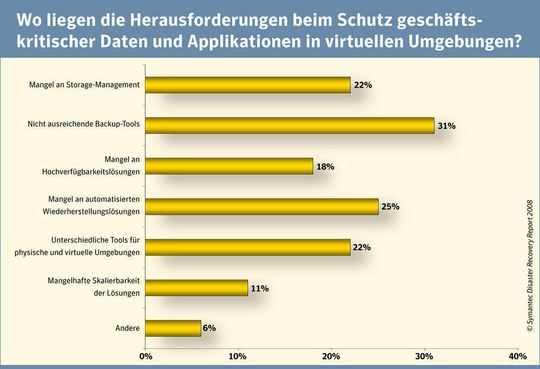

Dies beweist eine aktuelle Studie des Sicherheitsexperten Symantec mit 1.650 IT-Managern weltweit: Fast die Hälfte aller virtuellen Server sind nicht in die DR-Pläne der Unternehmen integriert. Die Motive reichen dabei von der unübersichtlichen Vielfalt der unterschiedlichen und teils unausgereiften Backup-Lösungen bis hin zu fehlenden Möglichkeiten einer Automatisierung für den Fall einer Wiederherstellung.

Vor allem aber folgende Aussagen dürften die Zurückhaltung bei IT-Verantwortlichen begründen: Bewährte Werkzeuge und Prozesse zur Hochverfügbarkeit und Disaster Recovery von physischen Servern lassen sich nicht auf virtuelle Szenarien adaptieren oder bieten nur einen eingeschränkten Funktionsumfang.

36 Prozent der Daten auf virtuellen Servern werden nicht regelmäßig in ein übergreifendes Backup einbezogen. Die Hauptgründe: mangelnde Speicherkapazitäten (52 Prozent) und fehlende Storage-Management-Tools (53 Prozent).

Riskant: Notfallpläne ohne Testlauf

Ferner kommt die im Juni dieses Jahres in 24 Ländern durchgeführte Erhebung zu dem Schluss, dass Notfallpläne nur selten geprüft werden. Sie sollen die alltäglichen Geschäftsprozesse nicht stören. 27 Prozent der Unternehmen testen diese Notfallpläne aus Gründen wie diesem gar nicht auf ihre Wirksamkeit – mit teils gravierenden Folgen. Denn bei einem Viertel der befragten Unternehmen versagte der Test.

Entsprechend düster muten die Worst Case-Szenarien an: Durchschnittlich drei Stunden benötigen Unternehmen, um eine Basisversorgung ihrer Systeme gewährleisten zu können. Nach rund vier Stunden erfolgt in der Regel wieder ein Normalbetrieb im Rechenzentrum.

Wie sich physische Server vor Ausfällen schützen lassen und was bei der Datensicherung zu beachten ist, erläutert Andreas Bechter auf der folgenden Seite.

(ID:2040659)

:quality(80)/p7i.vogel.de/wcms/24/c2/24c27aeefdf93876a395faa9790e6e40/0128909922v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/53/9a/539a7369f3f6420e59149463d2a30c44/0128372174v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/f7/01/f701d737e67de7edf60a815556f87792/0128380190v2.jpeg)

![KI in Deutschland: was muss passieren, dass Deutschland bei KI nicht den Anschluss verliert? (Bild: midjourney / KI-generiert - [M] J Rath) KI in Deutschland: was muss passieren, dass Deutschland bei KI nicht den Anschluss verliert? (Bild: midjourney / KI-generiert - [M] J Rath)](https://cdn1.vogel.de/OR9Fozt0vJYiF8WyvqFIobegcW8=/288x162/smart/filters:format(jpg):quality(80)/p7i.vogel.de/wcms/59/e9/59e942e7bcde7a66e41bfbb69823c213/0127869976v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/ea/44/ea4421ef6d8dcea0d10d9ab51823fe67/0129193951v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ff/64/ff64c80bbb54c2cc5bd3192564ca9b3f/0129132936v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/42/07/4207a6ae481716e03ae4ec1b66b3743d/0129161840v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/73/8a/738a14c02d5f128dc1aeeb97426878cb/0129113507v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/48/2a/482a0953bf55fcc497763f7dadb6c5d6/0129166170v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/58/9c/589c1ae4ba47109676e32d27326f4156/0129180939v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/d3/0f/d30f909ea304c3acfdd5bf0a6e54cfe7/0129179494v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/11/0f/110f00f836727507d8d29697099001f0/0129059286v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/04/f6/04f6ddd72255faee9ff9922cfedea951/0129047993v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/d8/24/d82467f22cedecb6b9e352aed1e7761f/0129130135v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/73/71/7371e98d1d3083c53e9c2e4547e1a95c/0129134273v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/1d/00/1d0036c8b1393bfba719437de22a0659/0129020958v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/98/50/9850475c7e7526e33d2cafc5ad0c5d1b/0128095819v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/76/cb/76cbe49cfea473087f6945c0ce27b878/0128603154v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/1c/93/1c9397c3fcd862e27d544c1da0a2e6ec/0128411324v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/1e/ab/1eab169e9eb77aed17ecb731bc0aaa81/0128441842v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/8a/3c/8a3ca24fcd1aad93d9217fad474cf3b4/0129050382v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/3d/4e/3d4eb05a9bb6148a258e1d7a320a0595/0128770700v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/37/68/3768a9690d67761ff08303668746b35f/0128683978v1.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/68/b9/68b9bb61e8f14/ic-logo-black-green.png)

:fill(fff,0)/p7i.vogel.de/companies/67/8a/678a22130528c/zadara-600.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/69/2e/692ecb7bb8f78/xopero-logo-color.png)

:quality(80)/p7i.vogel.de/wcms/82/3a/823a024f32d5377886dd691bd6869588/0127962027v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/b0/6a/b06a37ad7d593e61491e269d246822dc/0128407514v1.jpeg)