Anbieter zum Thema

Was bedeutet optimales Flash-Caching?

Durch den endlosen Strom an neuen Daten, die ständig erstellt und von strukturierten und unstrukturierten Datenbanken gesammelt werden, kann ein modernes Rechenzentrum mit einer durchschnittlichen Größe täglich problemlos Terabytes an Daten sammeln. Ein Teil dieser Daten wird angesehen, analysiert und mehrfach verwendet, aber das meiste davon wird nur ein einziges Mal nach dem Sammeln genutzt (es ist laut OCZ „ein schlecht gehütetes Geheimnis“ der DB-Administratoren, dass einige Daten nie wieder nach dem Abspeichern gelesen werden). Durch den Umfang an gesammelten Daten kann es schnell ineffizient werden, sämtliche Informationen auf Flash-Medien zu speichern. Daten, die – wenn überhaupt nur selten – wieder gelesen werden, können viel kostengünstiger auf magnetischen Medien gespeichert werden.

Andererseits bringen Daten, auf welche häufig zugegriffen wird, die IOPS-Fähigkeiten von magnetischen Laufwerken schnell an deren Leistungsgrenze, so dass Flash-Medien den besten Platz für die Speicherung dieser „Hot Data“ darstellen. Eine sofortige Leistungsverbesserung wird für Anwendungen bereits erreicht, wenn nur geringe Mengen der wichtigsten Daten auf überlegene Flash-Medien platziert werden. Wie das Sprichwort sagt „Wenn es um Performance geht, kann ein klein wenig Flash sehr viel bewegen.“ Das ist der Schlüssel zur Performance. Aber wie kann herausgefunden werden, welche Daten wichtig und es wert sind, in den Cache gespeichert zu werden?

Was soll in den Cache?

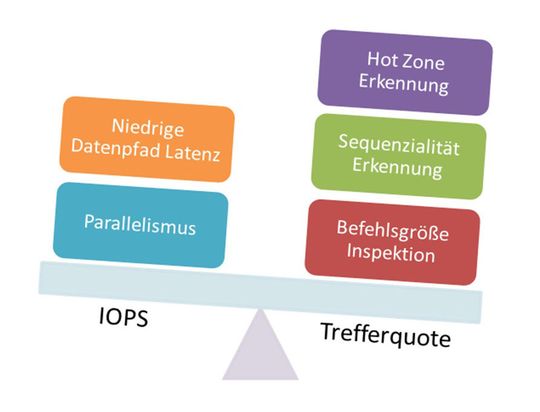

Die rechten Seite der Abbildung listet einige der wichtigsten Komponenten auf, welche von fortschrittlichen Caching-Anwendungen verwendet werden, um zu bestimmen, welche Daten in den Cache wandern. Wichtig ist die Wahrnehmung von „Hot Zones“ innerhalb der Daten, um die Positionen innerhalb der Volumina bestimmen zu können, auf welche häufig zugegriffen werden. Wichtig bei der Bestimmung, was in den Cache gelangt, sind auch die kritischen Eigenschaften der aufgerufenen Daten, wie die Befehlsgröße von Anwendungen und der sequentielle Umfang des Datenzugriffs. Dies wird irgendwann zusammenfassend als „Datenzugriff-DNA“ bezeichnet. Erweiterte Verfahren können diese Datenzugriffsmuster analysieren und verwenden diese Informationen als Teil der Auswahlkriterien, die bestimmen, welche Daten auf dem Flash gespeichert werden.

Letztlich zeichnet sich ein gutes Auswahlkriterium dadurch aus, dass die im Flash-Speicher abgelegten Daten zu jedem Zeitpunkt die wichtigsten Daten für die Anwendung sind. Dies gewährleistet, dass die Daten bereits auf dem Flash-Speicher warten, wenn die Anwendung auf sie zugreifen muss, und wird üblicherweise durch die Trefferquote gemessen (der Prozentsatz der Anwendungsanfragen für Daten, die vom Flash-Speicher beantwortet werden können).

„Catch 22“ des optimalen Flash-Cachings

Wie die obige Abbildung zeigt, sind sowohl Trefferquote als auch IOPS-Rating wichtig für die erfolgreiche Flash-Einbindung, was in traditionellen Architekturen einen Konflikt auslöst. Um eine bessere Trefferquote zu erhalten, müssen Caching-Software-Module statistisch gesehen die Daten in Echtzeit verarbeiten, um so vernünftig auswählen zu können, ob ein spezifisches Datenelement es wert ist, im Cachespeicher abgelegt zu werden. Je mehr Analysen die Software jedoch in Echtzeit zu erledigen hat, desto höher ist die Beeinflussung des Datenpfads zum Flash-Speicher. Dies ist ein klassisches Datenpfad-Design-Dilemma:

- 1. Wird zu viel Zeit damit verbracht, zu entscheiden, ob ein Datenelement zwischengespeichert werden sollte während es den Datenpfad durchläuft, verlangsamt das den Zugriff auf den Flash-Speicher.

- 2. Wird jedoch zu wenig Zeit darauf verwendet, werden für die Anwendung unnötige Daten im Cache gespeichert oder sogar kritische Daten aus dem Cache geworfen.

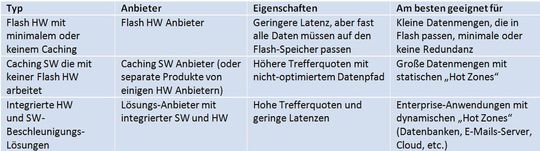

Dieses Design-Dilemma beeinflusst die Architektur der derzeit verfügbaren Lösungen und ermittelt die besten Einsatzgebiete für jedes Produkt.

Die Tabelle links ordnet die wichtigsten Arten von derzeit erhältlichen Beschleunigungsprodukten und zeigt jene Bereiche auf, für die sie jeweils am besten geeignet sind. Da Hardware-Anbieter ihre Produkte hauptsächlich für niedrige Latenz optimieren, ohne die intelligente Datenselektion zur Zwischenspeicherung, eignen sich diese Produkte am besten für einen Einsatz, wenn die Datenmenge klein genug ist, um komplett auf den Flash-Speicher zu passen. Wenn jedoch die Datenmenge über die Kapazität des Flash-Speichers wächst, wird Caching für die Beschleunigung benötigt. Dem gegenüber stehen die reinen Software-Caching-Lösungen, die ohne jeden Flash-Speicher arbeiten. Da diese Lösungen nicht mit der darunterliegenden Hardware kommunizieren können, versuchen sie möglichst häufig ihr Eingreifen zu minimieren. Sie neigen daher dazu, vereinfachte Caching-Entscheidungen zu bedienen und sind besonders für Fälle optimiert, bei denen die „Hot Data“ leicht zu identifizieren oder statisch sind.

Wenn sich jedoch die „Hot Zones“ des Datensatzes dynamisch verändern, ist eine tiefere Integration von Hardware und Software mit intelligenteren Caching-Ansätzen erforderlich. Enterprise-Anwendungen sind besonders anfällig für solche Optimierungen, da sie dynamisch große Datenmengen mit ständig wechselnder Wichtigkeit verarbeiten. Beispielsweise ein Data Warehouse, welches Echtzeit-Analysen basierend auf den neuesten Unternehmensdaten durchführt. Daten, die zu einem bestimmten Zeitpunkt kritisch sind und zwischengespeichert werden sollten, sind zu einem anderen Zeitpunkt nutzlos. Daher ist eine Selektion für die Zwischenspeicherung der besten Daten zu jedem Zeitpunkt stark von der aktuellen Zugriffsstatistik abhängig.

Das Beste beider Welten

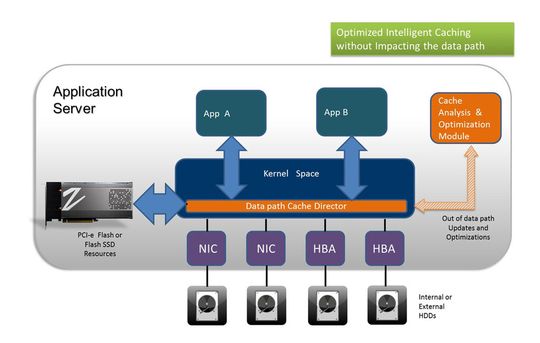

Ein sich abzeichnender neuer Ansatz für Enterprise-Caching, „Direct Pass Caching“, ermöglicht zum ersten Mal die auf Anwendungen optimierte Caching-Auswahl, während gleichzeitig die Zugriffszeiten auf den Flash-Speicher minimiert werden. Bei dieser neuen Architektur arbeiten Caching-Software und Flash-Datenpfad zusammen, um sowohl die „Trefferquote“ als auch die Zugriffsgeschwindigkeit auf den Flash-Speicher zu optimieren. Zwei Elemente bilden das Herz dieser Technologie: Ein Cache-Direktor und ein Cache-Analyse-Motor arbeiten im Einklang, um diese Ziele gleichzeitig zu erreichen.

Wie die Abbildung links dargestellt, ist der Direktor für den Datenpfad ein dünnes rationalisiertes Element, welches entsprechende Datenanfragen schnell an den Flash-Speicher weiterleitet, und dabei trotzdem noch in der Lage ist, hochentwickelte und statistisch optimierte Entscheidungen hinsichtlich der Daten zu treffen, welche zwischengespeichert werden. Um dies erfüllen zu können, wird für die Kommunikation mit dem Cache-Engine-Analyse-Modul außerhalb der Reihe eine API verwendet. Der Datenpfad-Cache-Direktor verwendet regelmäßige Updates, um die neuesten Informationen über Zugriffsmuster der Anwendungen dynamisch an den Caching-Motor zu senden. Der Caching-Motor ist dann in der Lage, außerhalb der Reihe tiefgreifende statistische Analysen zur Optimierung des Cachings durchzuführen. Der Caching-Motor kann dem Datenpfad-Cache-Direktor nun ein stetiges Feedback zu dynamisch optimierten Auswahlregeln zurücksenden. Auf diese Weise ist es dem Direktor möglich, ständig die richtige Wahl für die Zwischenspeicherung zu treffen, ohne aufwendige Analysen im Datenpfad durchzuführen.

Durch Kombination aus optimierter Datenpfad-Macht und erweitertem Caching-Analyse-Modul kann „Direct Pass Caching“ das Caching für Enterprise-Anwendungen optimieren. Diese Architektur liefert einerseits hohe Trefferquoten und bietet gleichzeitig den schnellsten Datenzugriff auf die On-Host-Flash-Ressourcen. Durch die geeignete Auswahl an Flash-Hardware und Software, welche bei einem erfolgreichen Flash-Einsatz hinsichtlich der wichtigsten Anforderungen zusammenarbeiten, können IT-Manager die ultimativen Ziele der Flash-Implementierung erreichen, beispielsweise eine deutliche Leistungssteigerung bei Endanwender-Anwendungen bei gleichzeitiger Reduzierung der Rechenzentrumskosten, erklärt OCZ.

(ID:40249720)

:quality(80)/p7i.vogel.de/wcms/24/c2/24c27aeefdf93876a395faa9790e6e40/0128909922v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/53/9a/539a7369f3f6420e59149463d2a30c44/0128372174v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/f7/01/f701d737e67de7edf60a815556f87792/0128380190v2.jpeg)

![KI in Deutschland: was muss passieren, dass Deutschland bei KI nicht den Anschluss verliert? (Bild: midjourney / KI-generiert - [M] J Rath) KI in Deutschland: was muss passieren, dass Deutschland bei KI nicht den Anschluss verliert? (Bild: midjourney / KI-generiert - [M] J Rath)](https://cdn1.vogel.de/OR9Fozt0vJYiF8WyvqFIobegcW8=/288x162/smart/filters:format(jpg):quality(80)/p7i.vogel.de/wcms/59/e9/59e942e7bcde7a66e41bfbb69823c213/0127869976v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/b7/3b/b73bce166acc4ab95790226ec52b48a1/0129323942v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/4b/ee/4bee19d172fd9c8c8993590986ba9c06/0129260266v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/81/37/8137ad44f55d3228683ef68cc3d96963/0129235950v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ea/44/ea4421ef6d8dcea0d10d9ab51823fe67/0129193951v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/f9/bb/f9bb3bb3f86b609e03fd022835ca731a/0129320644v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/cb/24/cb242bd94c1c922b7acd32be2c91c9d9/0129046254v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ad/e5/ade5de9fdf2919d873cd1384e173feec/0129269175v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/be/0e/be0ed0096a2afda65800231eb5d11d42/0129258967v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/00/8e/008e84664c492228d548f253867c1a4a/0128493241v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/6b/fa/6bfa3799ec2833886c5932834bb01668/0128802998v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/07/c1/07c10f0ef99b1aaa8ec4e689bab584d6/0129245033v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/66/22/66221b7a2c23107b972d002a3c8f6253/0129110244v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/04/f6/04f6ddd72255faee9ff9922cfedea951/0129047993v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/55/aa/55aa1085fca6b8cbeb7326cead80be35/0129191109v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/e1/da/e1dae6f55425d75714079fffad8e4ad1/0129247479v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/0f/77/0f771deb5ec0e397df095a914782ba79/0128876251v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/98/50/9850475c7e7526e33d2cafc5ad0c5d1b/0128095819v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/76/cb/76cbe49cfea473087f6945c0ce27b878/0128603154v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/1c/93/1c9397c3fcd862e27d544c1da0a2e6ec/0128411324v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/1e/ab/1eab169e9eb77aed17ecb731bc0aaa81/0128441842v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/8a/3c/8a3ca24fcd1aad93d9217fad474cf3b4/0129050382v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/3d/4e/3d4eb05a9bb6148a258e1d7a320a0595/0128770700v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/37/68/3768a9690d67761ff08303668746b35f/0128683978v1.jpeg)

:fill(fff,0)/images.vogel.de/vogelonline/companyimg/133500/133538/65.jpg)

:fill(fff,0)/p7i.vogel.de/companies/69/2e/692ecb7bb8f78/xopero-logo-color.png)

:quality(80)/p7i.vogel.de/wcms/d6/c8/d6c82f76189e9b0a809863f04f105688/0124351672v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/d6/a8/d6a8be0fbd68745bad298c97c04cf56d/0127608232v1.jpeg)